构建简单网络和优化方法—手写数字识别

日期: 2020-01-19 分类: 个人收藏 462次阅读

构建简单网络和优化方法—手写数字识别

文章目录

1,如何构建初始的“手写数字识别”神经网络?

1.下载MNIST_data集并把该数据集放在源.py/.ipynb文件的相同路径位置,并载入数据集。

2.自定义batch_size(每个批次读取图片的数量大小),并计算n_batch(总共的批次数)。

3.定义x和y,使用feed方法进行数据输入。

4.创建一个简单的神经网络,输入层为784个神经元,输出层为10个神将元。(需要注意的是:激活函数使用softmax(),用于将计算结果进行概率转换。)

5.损失函数使用二次代价函数,loss = tf.reduce_mean(tf.square(y-prediction))。

6.优化器使用梯度下降法,train_step = tf.train.GradientDescentOptimizer(xx).minimize(loss)。

7.结果存放在一个布尔型列表中,correct_prediction = tf.equal(tf.argmax(y,1),tf.argmax(prediction,1))#argmax返回一维张量中最大的值所在的位置。

8.定义准确率,accuracy = tf.reduce_mean(tf.cast(correct_prediction,tf.float32))。

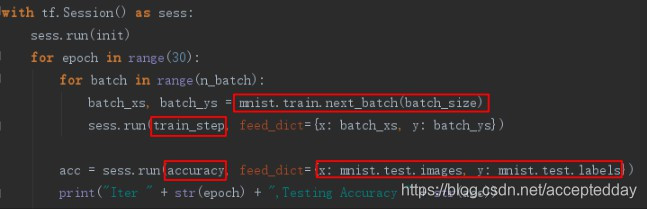

9使用默认图tensorflow.Session()进行训练并调用测试。(需要注意的地方:sess.run(train_step)使用的是train集,而sess.run(accuracy)使用的是test集。)

2,如何进行简单网络的优化?

1.对w,b的初始值进行优化。

W = tf.Variable(tf.truncated_normal([784, 3000], stddev=0.1))

b = tf.Variable(tf.zeros([3000])+0.1)

2.使用交叉熵函数作为损失函数。

#交叉熵函数

loss = tf.reduce_mean(tf.nn.softmax_cross_entropy_with_logits_v2(labels=y, logits=prediction))

需要注意的是:

在Tensorflow中用: tf.nn.softmax_cross_entropy_with_logits()来表示跟softmax搭配使用的交叉熵。

3.添加多个中间层,同时使用Dropout()防止过拟合发生。

#创建神经网络的中间层1

W1 = tf.Variable(tf.truncated_normal([784, 500], stddev=0.1))

b1 = tf.Variable(tf.zeros([500])+0.1)

predict1 = tf.nn.tanh(tf.matmul(x, W1)+b1)

drop_1 = tf.nn.dropout(predict1, keep_prob)

#创建神经网络的中间层2

W2 = tf.Variable(tf.truncated_normal([500, 300], stddev=0.1))

b2 = tf.Variable(tf.zeros([300])+0.1)

predict2 = tf.nn.tanh(tf.matmul(drop_1, W2)+b2)

drop_2 = tf.nn.dropout(predict2, keep_prob)

#创建神经网络的输出层

W3 = tf.Variable(tf.truncated_normal([300, 10], stddev=0.1))

b3 = tf.Variable(tf.zeros([10])+0.1)

prediction = tf.nn.softmax(tf.matmul(drop_2, W3)+b3)

注:keep_prob为随机抽取同一层神经元的比例,神经元个数控制在数据集相近。

4.使用优化器AdamOptimizer,减小学习率的变化速度

#定义变量学习率lr,初始化为0.001

lr = tf.Variable(0.001, dtype=tf.float32)

#使用AdamOptimizer优化器

train_step = tf.train.AdamOptimizer(lr).minimize(loss)

#在迭代中设置学习率变化幅度

sess.run(tf.assign(lr, 0.001*(0.95**epoch)))

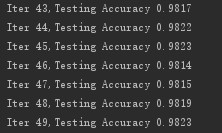

本题采用以上4种优化方法后优化效果较好。

优化后的测试结果:

附:优化前的简单网络的构建代码—手写字体识别:

#载入数据集

mnist = input_data.read_data_sets("MNIST_data",one_hot=True)

#每个批次的大小

batch_size = 100

#计算一共有多少个批次

n_batch = mnist.train.num_examples // batch_size

#定义两个placeholder

x = tf.placeholder(tf.float32,[None,784])

y = tf.placeholder(tf.float32,[None,10])

#创建一个简单的神经网络

W = tf.Variable(tf.zeros([784,10]))

b = tf.Variable(tf.zeros([10]))

prediction = tf.nn.softmax(tf.matmul(x,W)+b)

#二次代价函数

loss = tf.reduce_mean(tf.square(y-prediction))

#使用梯度下降法

train_step = tf.train.GradientDescentOptimizer(0.2).minimize(loss)

#初始化变量

init = tf.global_variables_initializer()

#结果存放在一个布尔型列表中

correct_prediction = tf.equal(tf.argmax(y,1),tf.argmax(prediction,1))#argmax返回一维张量中最大的值所在的位置

#求准确率

accuracy = tf.reduce_mean(tf.cast(correct_prediction,tf.float32))

with tf.Session() as sess:

sess.run(init)

for epoch in range(21):

for batch in range(n_batch):

batch_xs,batch_ys = mnist.train.next_batch(batch_size)

sess.run(train_step,feed_dict={x:batch_xs,y:batch_ys})

acc = sess.run(accuracy,feed_dict={x:mnist.test.images,y:mnist.test.labels})

print("Iter " + str(epoch) + ",Testing Accuracy " + str(acc))

除特别声明,本站所有文章均为原创,如需转载请以超级链接形式注明出处:SmartCat's Blog

精华推荐